ChatGPTなどの生成AIを、議事録作成や計画書づくり、相談対応に使ってみたい!

障害福祉の支援現場でそう感じている支援者・管理者の方は、ここ数年で一気に増えていると思います。

一方で、

- 個人情報を入れて大丈夫なのか?

- 法令違反にならないか心配で、結局ほとんど使えていない

- 職員が勝手に無料版のAIを触っていて不安…

といったご相談もよくパパゲーノに寄せられます。

そこで本記事では、障害福祉施設でAIを使う上での「法務リスク」と対策を詳しく解説します。

障害福祉施設でAIを使うとき、どこに法務リスクがあるのか?

個人情報保護法を遵守するために、最低限おさえるべきポイントは何か?

を初学者向けにできるだけ噛み砕いて整理しているので、ぜひ事業所でのAI活用をする際にお役立てください。

本記事は一般的な情報提供であり、個別ケースの最終判断は必ず弁護士等の専門家にご相談をお願いします。

なぜ障害福祉施設のAI活用に「法務リスク」が重要なのか?

障害福祉の現場は「要配慮個人情報」が多い

障害福祉の現場では、以下のような情報を日常的に扱います。

- 障害名・診断名

- 通院状況・服薬状況・既往歴

- 生活歴・就労歴・家族関係

- 逮捕歴

- 宗教

- 相談内容(メンタル・トラウマなど)

これらは「要配慮個人情報」と呼ばれ、「不当な差別や偏見が生じるおそれが高い情報」として、個人情報保護法の中でも特に厳しい管理が求められます。

同じ「AI活用」でも、一般企業のマーケティングや業務効率化にAIを使うのと、障害福祉施設でAIを使うのとでは、法務リスクの重さが全く異なるということをまずは理解しましょう。

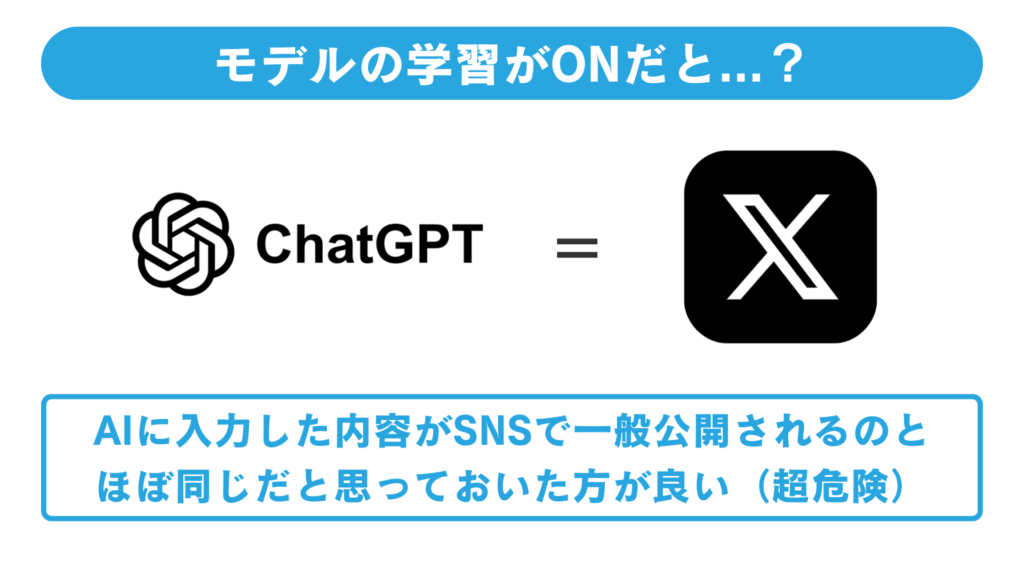

「ChatGPTにコピペ=ほぼSNSで公開」と同じリスク!?

特に注意が必要なのが、ChatGPTなどの一般向けの対話型AIサービスです。例えば、ChatGPTの無料版は初期設定としてAIモデルの学習に入力した内容(プロンプト)が使われる設定になっています。

無料版・個人向けプランでは、AIに入力した内容がモデルの学習に使われる設定が「オン」になっていることが多い

AIモデルの学習に使われるということは、つまり、入力した内容が将来、どこかの誰かへのAIの回答に自分の質問内容が使われる可能性があるということになります。

極端に言えば、XやFacebookなどのSNSに公開しているのと近い状況です。仮に、事業所の利用者さんとの面談記録をAIに入力した場合、重大な情報漏洩をしていることになります。

やすまさ

やすまさモデルの学習を「OFF」にするだけでは、日本の個人情報保護法を遵守した形で、生成AIを福祉現場で使うことはできないので、さらに注意が必要です!

そもそも「個人情報保護法」とは?

個人情報保護法は、個人情報の適切な取り扱いについて定めた日本の法律です。正式名称は「個人情報の保護に関する法律」で、2003年に制定され、2005年から全面施行されました。

個人情報保護法の目的は大きく2つあります。個人の権利・利益を守ることと、個人情報の有用性に配慮しながら適正な活用を促進することです。つまり「守る」と「活かす」のバランスを取る法律です。

事業者の主な義務

- 利用目的の特定と公表

- 目的外利用の禁止

- 適切な安全管理措置

- 第三者提供時の本人同意の取得

- 本人からの開示請求への対応

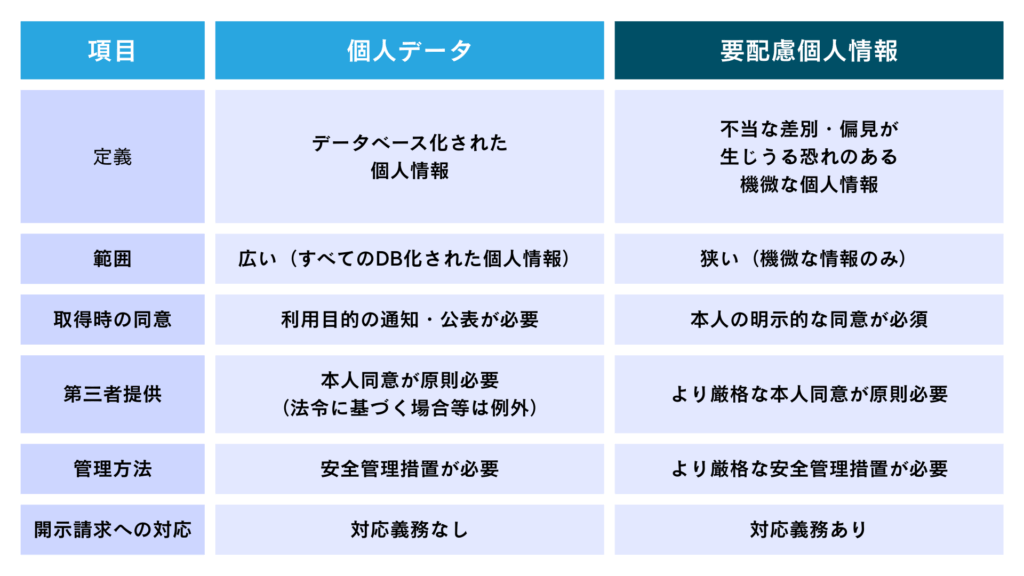

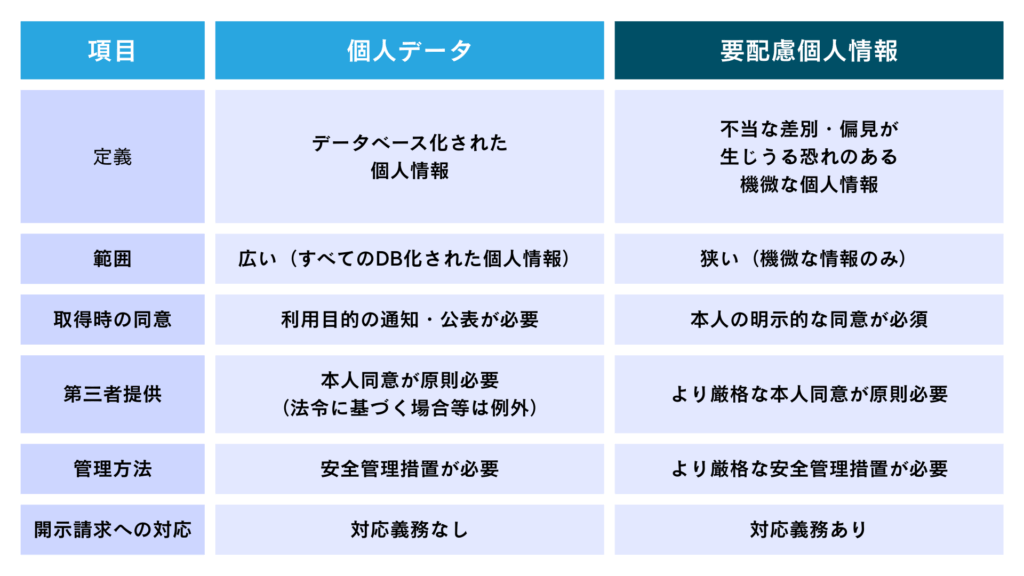

個人情報 / 要配慮個人情報 / 個人データ

個人情報保護法では、情報の性質や管理状態によって区分があり、それぞれ守るべきルールが異なります。

| 個人情報 | 氏名、住所、メールアドレス、顔写真など、誰の情報か特定できるもの |

|---|---|

| 要配慮個人情報 | 健康情報、障害・病歴、信条、性生活 など、差別や偏見につながりやすい情報。 → 取得も利用も、原則「本人の明示的同意」が必須。 |

| 個人データ | 名簿やシステム上で「データベース化」されている個人情報。 → 管理・安全対策がより厳しく求められる。 |

要配慮個人情報は、必ずしもデータベース化されていない断片的な情報でも該当します。そのため、障害福祉の現場で取り扱う情報は、多くが「要配慮個人情報」だと考えておいた方が良く、最も高いレベルの保護が求められます。

「第三者提供」と「委託」の違い

要配慮個人情報を「第三者提供」する際は、必ず本人の同意が必要です。

要配慮個人情報をAIのサービスに入力したり、Excelに入力することは「第三者提供」に該当するのでしょうか?

日本の個人情報保護法には、円滑に事業運営をできるように「第三者提供」には該当しない例外規定が

クラウドやAIサービスに情報を渡したとき、それが第三者提供なのか業務委託(処理をお願いしているだけ)なのかで、求められる対応が変わることになっています。

委託とは?

自社の業務を外部に任せるために、自社の管理下で個人データを預けることです。本人の同意は不要(法律上「第三者」に該当しないため)です。

- 給与計算を社労士事務所に依頼する

- Excelに生年月日を入力する

- クラウドシステム(SaaS)にデータを保管する

- ラクスルなどの印刷業者にDM発送を依頼する

などが該当します。

第三者提供とは?

個人データを別の事業者に、その事業者自身の目的で使わせることです。

原則:本人の同意が必要(要配慮個人情報は例外なく同意必須)

- 利用者情報を他の福祉事業所に紹介のため共有する

- 相談支援事業所に利用者さんの通所状況を報告する

- 顧客リストを提携企業に渡す

などが該当します。

| 委託 | 自社の業務を外部に任せるために、自社の管理下で個人データを預けることです。 「この目的のためだけに処理してね。勝手に他のことに使わないでね。」と契約で縛り、事業者がデータを他の目的に使い回さない状態の場合「委託」と整理できる。 |

|---|---|

| 第三者提供 | AI事業者側が、監視やモデル改善など別の目的にも使う前提になっている状態の場合、「第三者提供」に該当すると判断される。 |

ChatGPTなど多くの生成AI系サービスは、入力したプロンプトの内容が一定期間保存され、監視やシステム改善などに利用されるため、第三者提供になる可能性が高いと考えられています。ここが法務リスクの大きなポイントになっています。

法律の専門家の間でも「委託」か「第三者提供」かの議論は分かれているので、慎重な判断が必要です。

障害福祉施設でありがちな3つの法令違反事例

次に、実際に障害福祉の支援現場で「やりがちなNG例」を対策とセットで紹介します。

事例① メール相談文をそのままChatGPTに貼り付け

利用者さんからのメール相談を、実名・年齢・病名そのままでAIにコピペして、「どう返事をしたらいいか?」と聞いてしまった。

問題点

実名・年齢・診断名・相談内容がそろうと、要配慮個人情報になります。本人の明示的な同意なくこれらをAI事業者に渡すと、要配慮個人情報の第三者提供にあたる可能性が高いです。

望ましい対応

可能な限り匿名化して「40代男性」「統合失調症のある方」などの形で入力しましょう。

匿名化とは、この情報だけでは誰か特定できないので、一般公開しても問題ないレベルの情報です。判断が難しい場合は、施設長などに相談しましょう。

事例② 面談の録音を書き起こして丸ごとAIに要約させる

事業所のサビ管Aさんは、面談記録の効率化のために面談を録音し、文字起こし。その全文をAIに貼り付けて「要約して」と依頼した。要約結果を見て利用者さんも喜んでいたので、問題ないだろうと考えていた。

問題点

面談の書き起こしには、ほぼ確実に、実名、過去の病歴、家族構成、トラウマ経験などが含まれ、一般的なAIサービスでは、入力内容が一定期間保存され海外のサーバー(米国など)に送信されます。

そのため、要配慮個人情報の第三者提供、かつ海外移転(より厳しいルール)の問題が重なってしまいます。

望ましい対応

理想は個人を特定できる情報を削ったうえで要約に使う。または、越境移転に対応した形での本人同意の取得や医療・福祉向けに設計された専用サービスを利用する。

事例③ 無料版AIに個別支援計画のPDFをアップロード

スタッフが無料版のChatGPTを使い、個別支援計画書のPDFをアップして要約させた。無料でも便利に使えるため、このような無断利用が常態化していた。

問題点

無料版・個人向けサービスでは、入力内容がモデル学習に利用される設定になっていることが多いため、支援計画の内容が将来どこかの回答に紛れ込んでしまうリスクがあります。また、利用規約上、無料版の生成AI系サービスは、商用利用が禁止されている場合もあります。

望ましい対応

原則として、 無料版を業務利用しない(ルール化する)

特に気をつけたい3つの原則

個人情報は基本的にAIに入れない

まずは「個人情報はAIに入れない」ということを大原則と考えると、安全側に生成AIを福祉現場で使うことができます。

- 氏名、住所、電話番号

- 障害名・病名・服薬状況

- 相談内容そのもの など

これらをそのままAIに入力するのは避けるようにします。どうしても必要な場合は、きちんとした同意と専用システムが必要です。

SNSにそのまま投稿しても問題にならないレベルまで情報を削る

くらいの感覚で匿名化すると、匿名加工が徹底できるので良いでしょう。

例えば、以下のようなプロンプトであれば、個人を特定するのは困難なため問題ないと言えます。

40代男性、精神疾患のある利用者さんからの相談文の一部です。最近、支援者との関係に悩んでいます。支援者としての返答を作成してください。

〜〜〜匿名化された相談内容〜〜〜

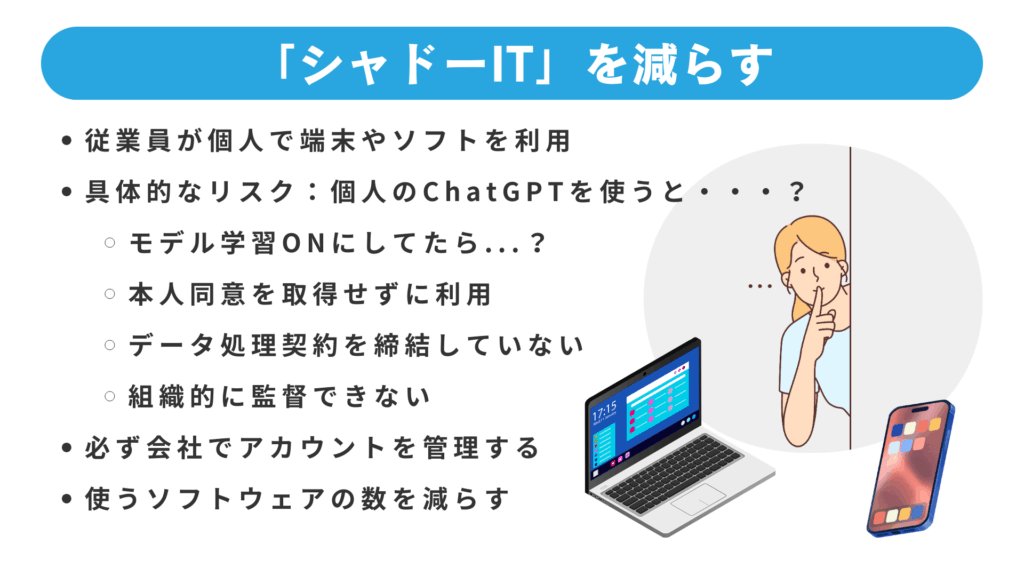

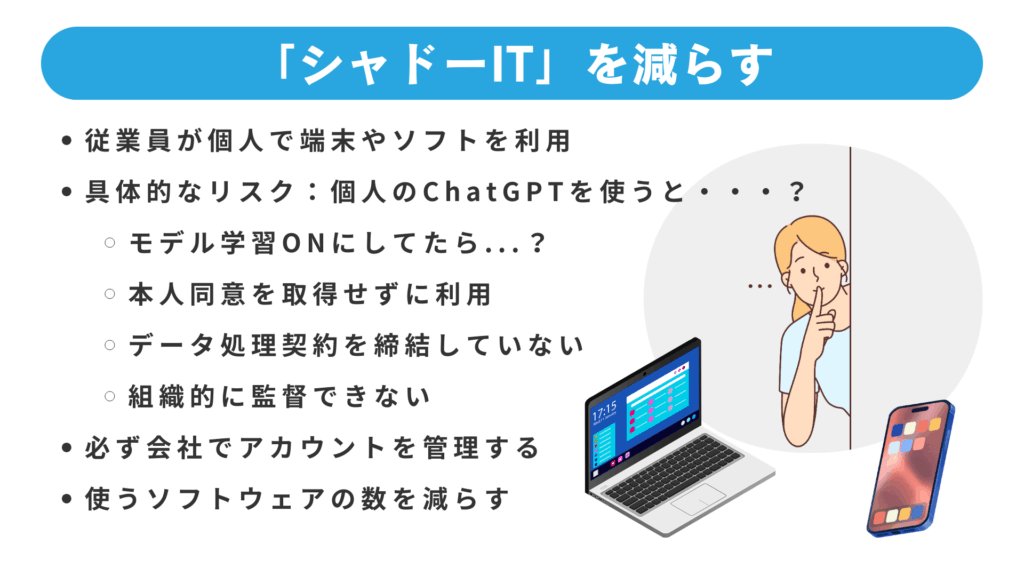

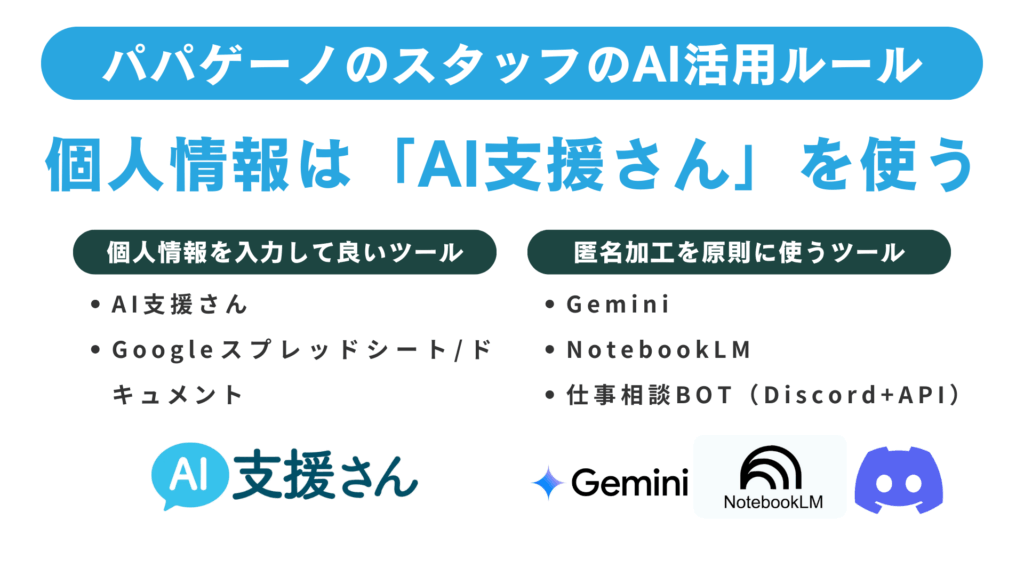

シャドーIT(無断利用)をなくす

障害福祉の現場で最も危険なのは、組織が把握していないAI利用です。

- 私物スマホから無料版AIにアクセス

- 個人のチャットGPTアカウントで支援記録を加工

- 無断で新しいAIアプリをインストール

こうした無断でのIT利用を「シャドーIT」と呼びます。

- モデル学習設定の確認ができない

- 利用規約を守っているか不明

- 本人同意・説明との整合が取れない

などの意味で、大きな法務リスクになります。

「AIを使っていいのは、このアカウントと、このサービスだけ」

「この範囲の情報だけ入力してよい」

といったルールと教育が不可欠です。

いきなりゼロにするのが難しくても、徐々に減らすことや、シャドーITの危険性を周知することから始めることが重要です。

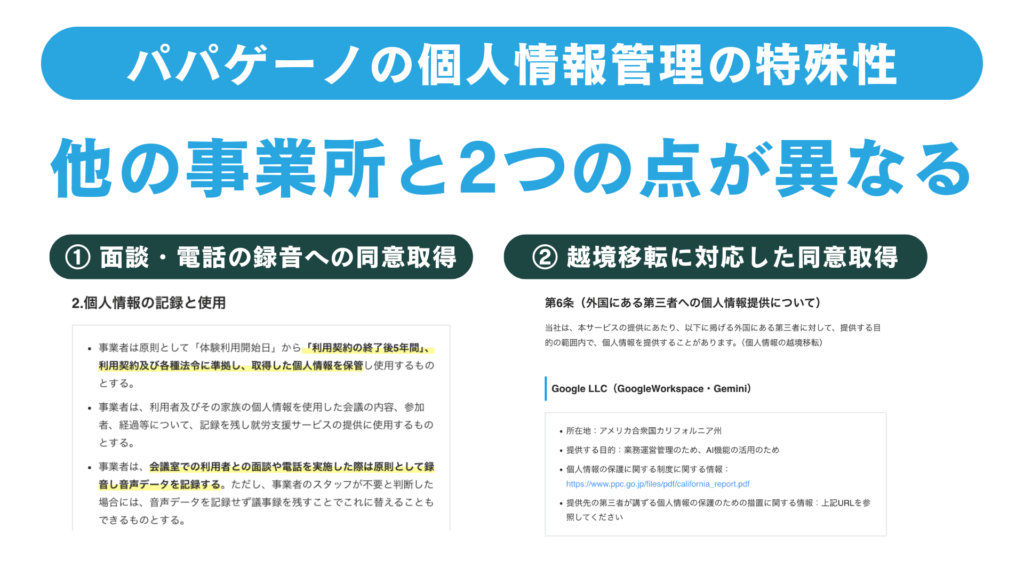

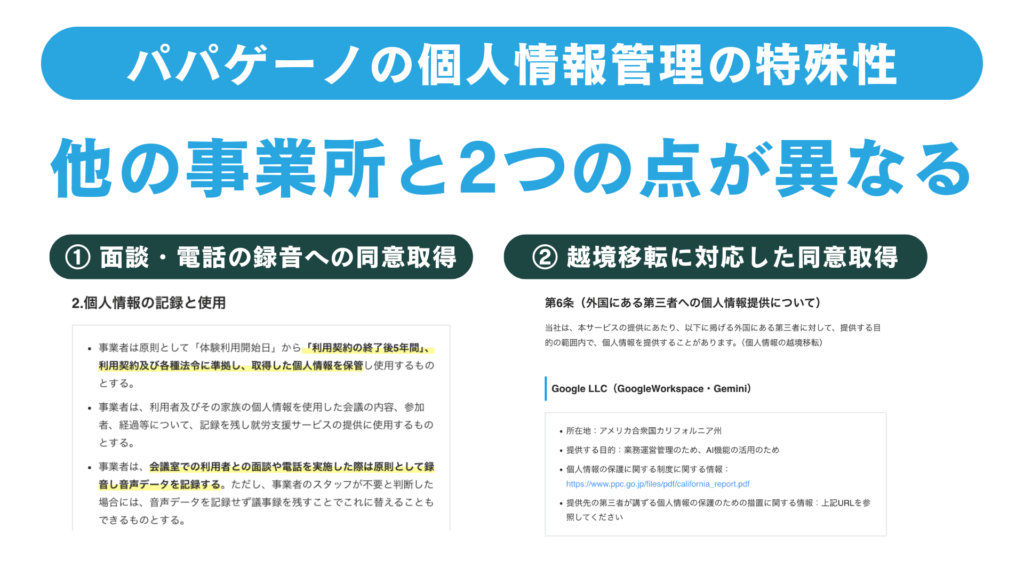

海外サーバーへの「移転」を意識する

多くのAIサービスは、海外(主に米国など)のサーバーで動いています。個人情報保護法では、個人データを海外の事業者に渡すことを「外国第三者提供(移転)」として、追加のルールを課しています。

そもそも個人情報を入れない(匿名情報だけにする)ようにするのが原則ですが、要配慮個人情報を含む内容で生成AIを活用したい場合は、越境移転に対応した同意を取得した上で、AI事業者と「データ処理契約(DPA)」を締結する必要があります。

障害福祉施設がやるべき情報セキュリティの対策

最後に、障害福祉現場のAI活用を推進する上で、障害福祉施設がやるべき情報セキュリティの対策をまとめます。

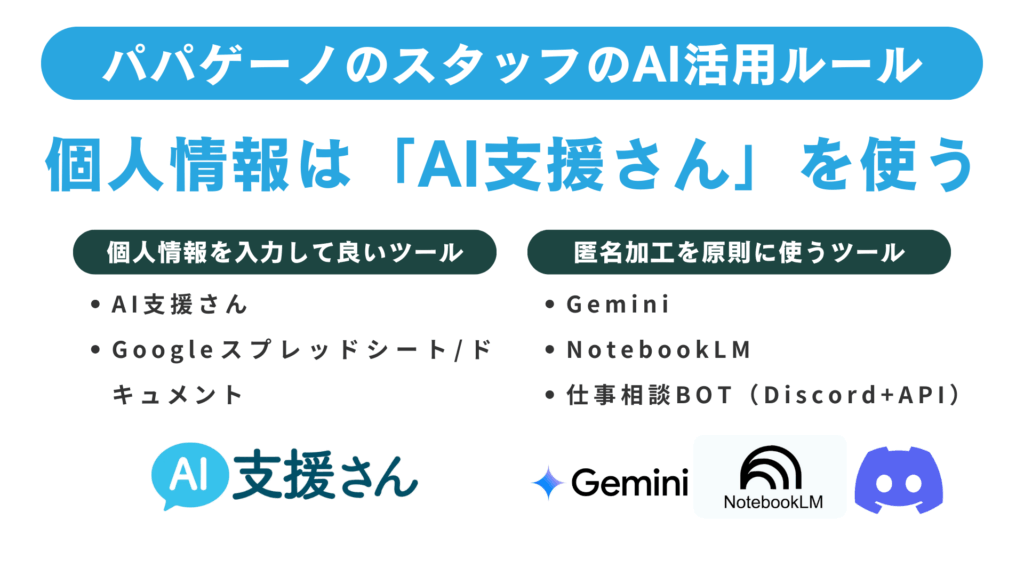

ITツールの選定とルール整備

まずは利用するツールを選び、ルールを明確化します。AIのモデル学習をオフにできるかどうか、また、利用規約上、業務利用や医療・福祉用途が想定されているかをまず確認することが大切です。

ChatGPTやGeminiなどのサービスを利用する場合は、データ処理契約(DPA)を結ぶことが必須になります。

AIに「入力してよい情報」と「入力してはならない情報」を明文化し、個人による無料アカウントでの利用を禁止します。また、ツールのインストールやアカウント登録は管理者を経由する形に限定し、ログイン情報の管理方法(パスワードの扱い方や二要素認証、SSOの利用など)についてもあらかじめルールを定めておくことが重要です。

使うツールの数が多いと、人為的なミスも起こりやすいです。シンプルな運用ルールにするのがおすすめです。

スタッフ向けの情報セキュリティ研修

次にスタッフ向けの研修を実施します。まずは正しい知識を学んで、適切な情報の取り扱いができるようにしましょう。

AIの出力には「ハルシネーション(もっともらしい誤情報)」が含まれることがあるため、AIが生成した内容をそのまま信用せず、必ず人が確認・判断することも重要です。そのようなAIを使いこなすための教育も同時に大切になります。

スタッフ向けの「はじめての生成AI研修」や「情報セキュリティ研修」、社内ポリシー策定のコンサルティング等のご相談も気軽にお問い合わせください!

本人同意・説明文書の整備

どのAIサービスをそんな目的で使用するのか、データが海外のサーバーに保存されるかどうかについて明示します。これらの内容を契約書や重要事項説明書などに盛り込み、適切に同意取得できるようにします。

越境移転がある場合は、その国の個人情報保護制度の情報を提供した上で同意取得します。

事業所で使っている全てのITツールをリスト化して、目的や用途を明示するのがおすすめです!

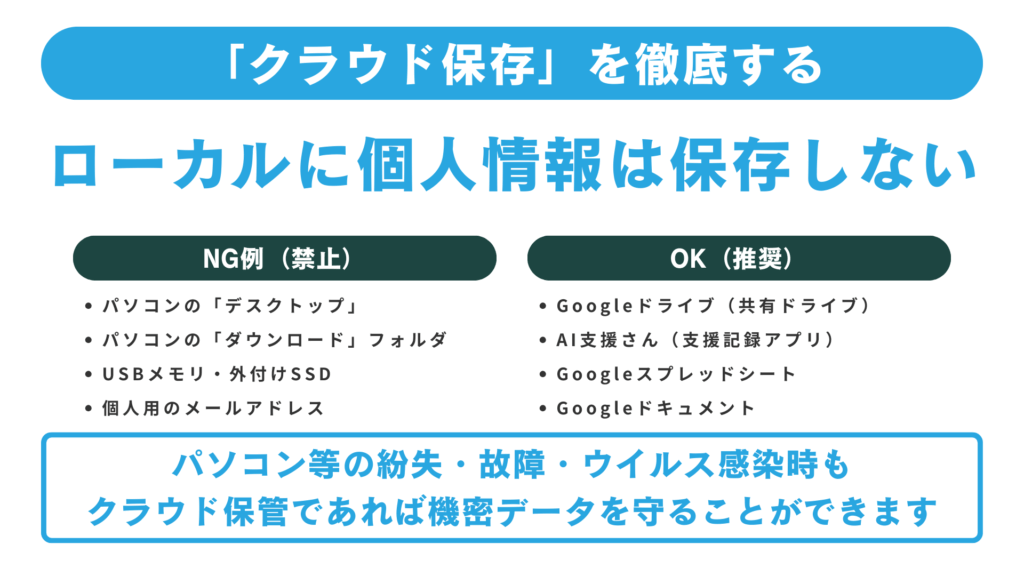

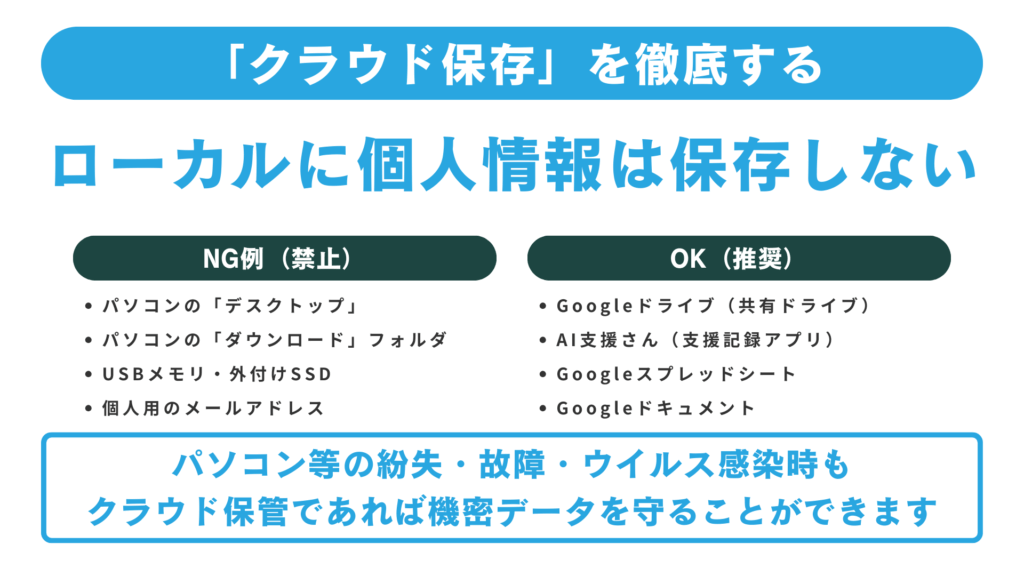

その他の基礎的なセキュリティ対策

AIに限らず、USBメモリやローカルディスクに支援記録を保存しないことや、PC内のローカルファイルを暗号化しておくことは重要です。

他もに、Googleドライブ等のクラウドサービスを利用する場合にも、「リンクを知っている全員が閲覧可」といった設定は避け、事業所内ドメインのみに閲覧権限を限定することが望ましいです。組織外部に共有する際は、施設長がルートフォルダの権限を変更するような運用が良いでしょう。

パスワード管理や二要素認証、SSOなど基本的な対策も法務リスクの軽減に直結します。

個別支援計画でAIを使うときの「安全なライン」は?

最後によくある質問を1つだけ取り上げます。

個別支援計画を作成する際に、生成AIを使ってもいいですか?

就労継続支援B型/A型など、多くの福祉施設では数ヶ月に1回の個別支援計画を作成しています。この作成に生成AIを使うことは問題ないのでしょうか?

比較的安全な使い方:匿名加工を徹底して使う

氏名や診断名は一切入力せず、「30代男性・就労継続支援B型利用中」といった程度の情報にとどめます。目標や支援方針については抽象度を上げたメモだけを入力し、「この内容を支援計画の文章として整えてください」といった形で活用する方法が望ましいです。

危険な使い方:そのままAIに入れる

面談の録音を全文文字起こししてそのまま貼り付けたり、実名・住所・通院先・服薬状況などを含めた状態で入力したり、個別支援計画やサービス等利用計画のPDFをアップロードするのは避けるべきです。特に、無料版AIや個人アカウントで処理することはリスクが高い行為です。

結論としては、「徹底した匿名化」を行ったうえで、文面の下書きづくりや表現の整理といった限定的な用途にとどめるのが安全です。

個人を特定できる情報を含めてAIを活用したい場合には、本人の明示的な同意を得たうえで、専用システムの利用や専門家によるチェックを組み合わせることが必要です。

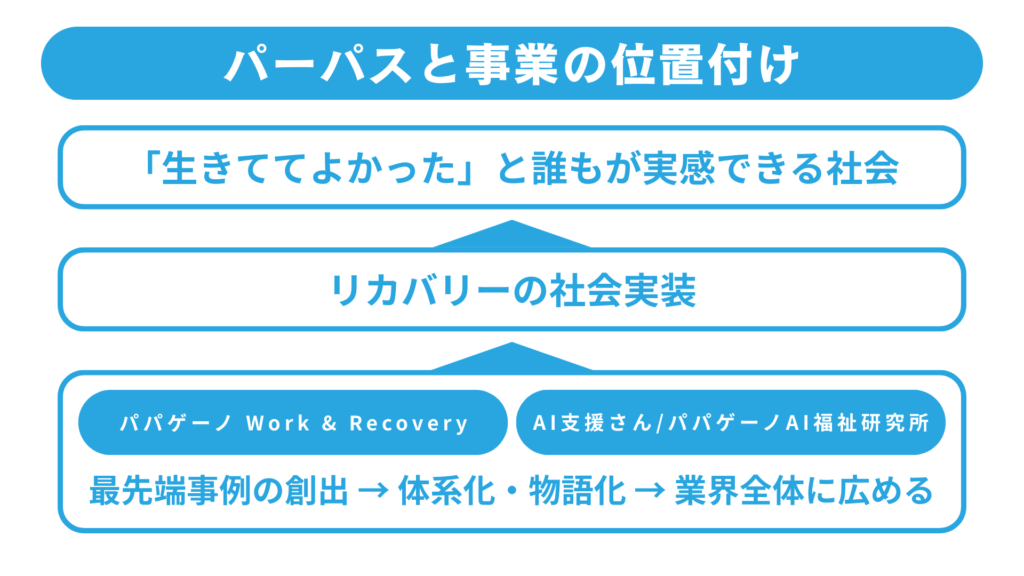

これからルールを「一緒に作っていく」段階

障害福祉とAIの関係は黎明期にあります。現場での活用事例も、行政や業界団体によるルールも、これからみんなで作っていく段階です。

だからこそ、各事業所の経営者・管理者・支援者が、法務リスクの「大枠の構造」を理解し、自分たちの現場に合ったルールを作り、それを実践しながら、うまくいかなかった点を互いに共有していくことが、とても重要だと感じています。

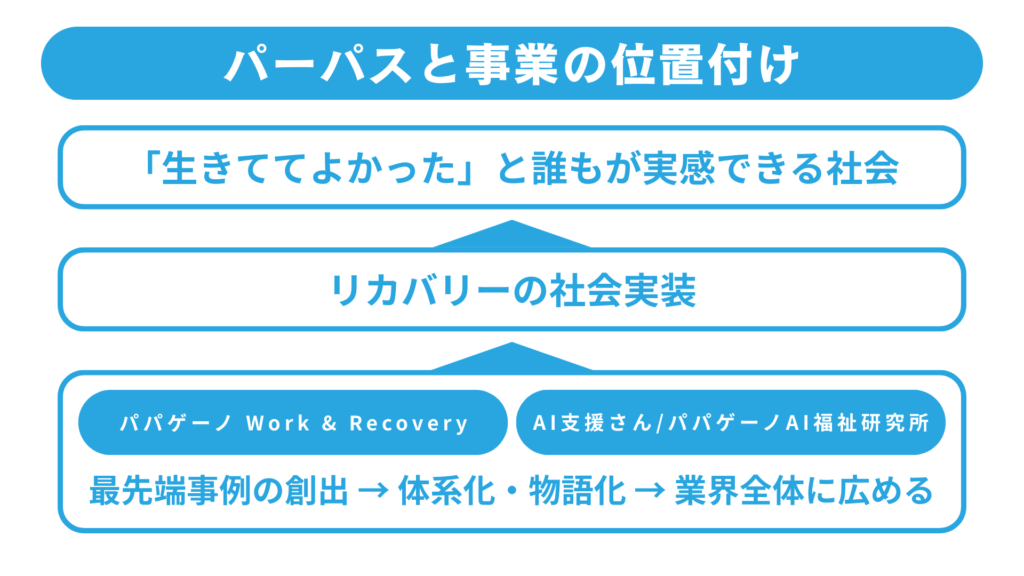

パパゲーノでも、就労継続支援B型事業所の運営と、AI活用ツール「AI支援さん」の開発を通じて、「利用者さんの安心・安全」と「支援現場の業務効率・支援の質向上」の両立に挑戦しています。

現場で実際にAIを使ってみての疑問や不安があれば、ぜひ遠慮なくご相談ください。皆さんと一緒に、「正しく怖がりながら、うまく活用する」ためのルールづくりを進めていけたら嬉しいです。

「AI支援さん」を現場で試してみたい方へ

生成AIを支援現場で導入したい方には、パパゲーノが開発した支援記録AIアプリ 「AI支援さん」 がおすすめです。

- 面談やケース会議の音声を録音するだけでAIが支援記録を作成

- 事業所ごとの Word・Excel フォーマットに合わせた書類のAI生成にも対応

- 相談支援・就労系・通所系など、さまざまな福祉・介護事業所で導入が進んでいます